Anything LLM ist ein Open Source KI-Chat-System mit RAG-Funktionalität,

das wir für Ihr Unternehmen binnen kürzester Zeit zur Verfügung stellen können.

Stellen Sie sich folgendes Szenario vor:

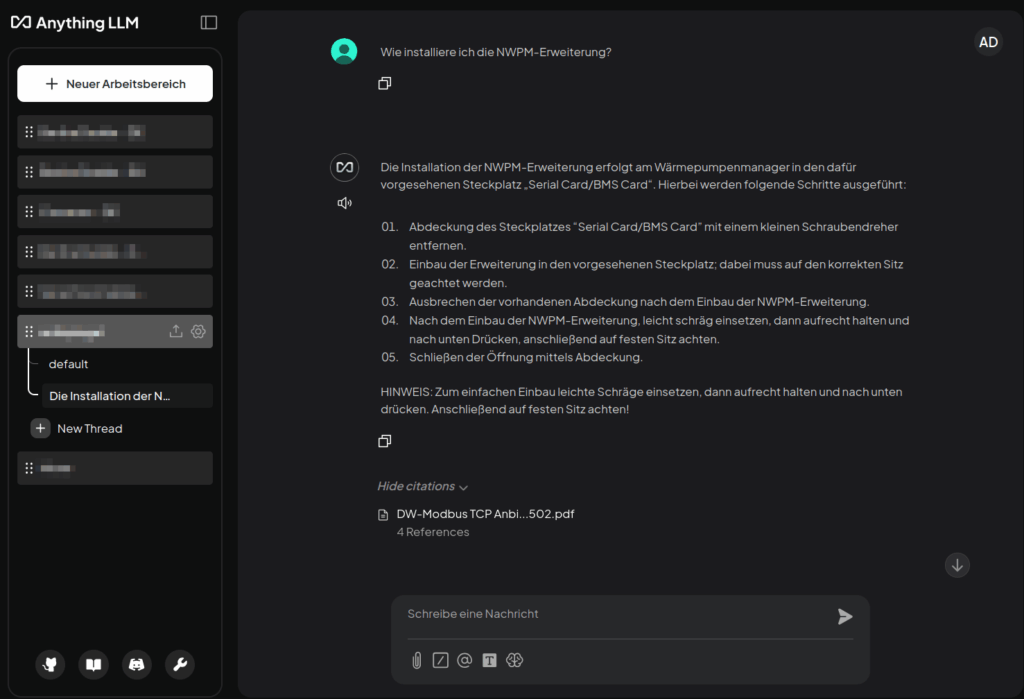

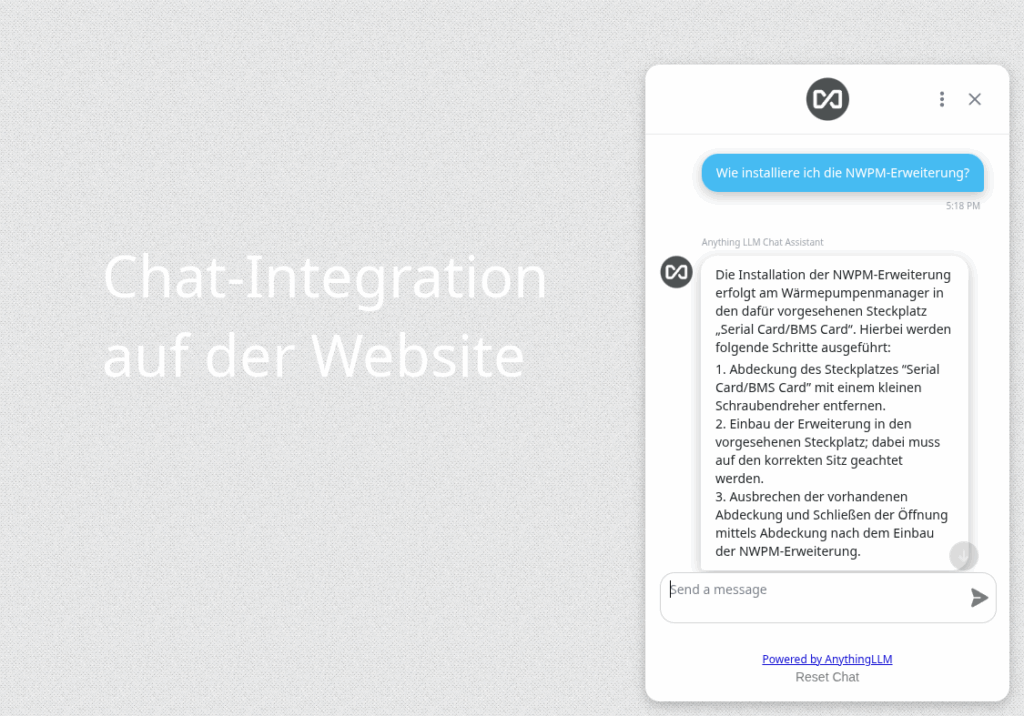

Sie wollen Ihren Kunden über Ihre Webseite einen KI-Chat zur Verfügung stellen, der in Supportfragen rund um Ihre Produkte weiterhelfen kann. AnythingLLM bietet dafür den Upload Ihrer Dokumente und deren Verarbeitung in einer konfigurierbaren RAG-Pipeline (Textsplitting/Chunking, Vector-DB-Embedding) wie auch die Ausgabe eines Chat-Clients oder aber die Abfrage der REST-API.

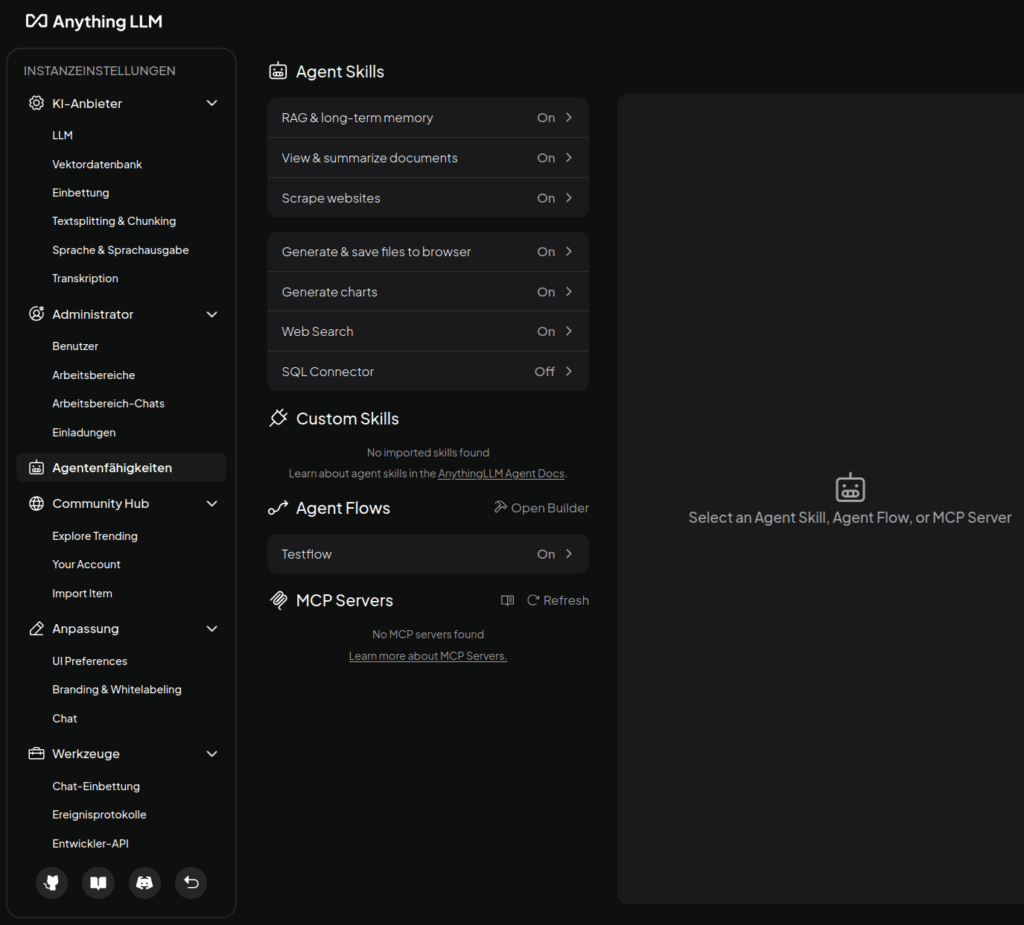

Die Wahl der Details bleibt dabei Ihnen überlassen: etwa bzgl. des zu verwendenden KI-Sprachmodells* (LLM), der Vektordatenbank, des Embedding-Verfahrens oder der Sprachein- und -ausgabe.

Wir helfen Ihnen mit der Expertise aus vergangenen Projekten bei der Implementierung und Optimierung dieser KI-Lösung.

Unser AnythingLLM-Hosting ist für Sie die richtige Wahl,

- falls Sie die strikte Abrechnung pro Benutzer trotz geringer Nutzungsintensität scheuen: wir machen Ihnen ein attraktives Angebot, das auf Ihre Nutzung hinsichtlich Browserrequests und Diskspace zugeschnitten ist, mit beliebig vielen Benutzern.

- falls Sie wissen wollen, wo ihre Daten gespeichert werden: wir verwalten Ihre isolierte AnythingLLM-Instanz auf dedizierter Hardware der Agitos GmbH in Deutschland, DSGVO-konform; wir nutzen bewusst keine Cloud-Rechenzentren, etwa großer US-Unternehmen.

- falls Sie wissen wollen, wer Ihre Daten administriert: lediglich unser Team hat Zugriff auf Ihre AnythingLLM-Instanz, es gibt keinen indirekten Zugriff über Plattformen von Drittanbietern, die etwa der Jurisdiktion anderer Länder unterliegen.

- falls Sie individuellen Support benötigen und die gleichen Ansprechpartner erreichen wollen, die Sie beim letzten Telefonat gesprochen hatten.

- falls Sie besondere Anpassungen benötigen, etwa individuelle Programmierung, die Anbindung einer externen Datenbank, Einbindung von MCP-Servern, Zugriffseinschränkung auf IP-Ebene, Monitorings oder API-Zugriff.

- falls Sie langfristig an Ihre Daten herankommen wollen: auf Wunsch können Ihre eigenen Linux-Administratoren Zugriff auf Ihre AnythingLLM-Instanz erhalten / bei Bedarf können wir bzgl. Datenexport weiterhelfen.

- falls Sie erwägen, die AnythingLLM-Instanz On-Premises zu betreiben: wir bieten Ihnen an, Ihre AnythingLLM-Instanz in Ihr internes Netz zu verschieben (auf Basis von LXD-Servern).

- falls Sie Open Source mit unterstützen wollen: 10% der Erlöse gehen den AnythingLLM-Entwicklern zu.

- Einstiegsangebot:

10 GB Speicherplatz (inkl. System)

beliebig viele Benutzer

nächtliche Sicherung

deutsches Rechenzentrum

monatliche Kündigung

SSL-Verschlüsselung unter bspw. https://ki-chat.ihredomain.tld

25 € pro Monat

… sowie individuelle Softwareentwicklung zum attraktiven Stundensatz.

* je nach Wahl des LLM-Service müssen Zusatzkosten berücksichtigt werden.

Eine öffentliche AnythingLLM-Demo können wir aus Gründen des potenziellen Mißbrauchs nicht zur Verfügung stellen; fragen Sie uns bei Interesse dennoch an, wir finden eine Lösung.

Unverbindliche Beratung und Angebot anfordern

Weitere Informationen: